{{item.title}}

{{item.text}}

{{item.text}}

AIによるビジネスチャンスはどのくらいあるのでしょうか。PwCの調査によると、AIが2030年までに世界経済に与える影響は15.7兆米ドルと試算されています。AIによる生産性向上、そして、AIを搭載した製品やAIを活用したサービスによる消費者需要の増加が主な要因です。AIの活用はあらゆる業界へ広がりを見せています。顧客サービス、販売からバックオフィスの自動化まで、あらゆる領域へ影響を及ぼしているといっても過言ではありません。AIがもたらす変革の可能性は、経営幹部にとっても関心事です。『第22回世界CEO意識調査』によると、今後5年間でAIがビジネスのやり方を大きく変化させると回答したCEOは、72%にも達します。

ここで忘れてはいけないのは、AIが秘めた大きな可能性の裏にある大きなリスクです。貴社のAIアルゴリズムは貴社の価値観に合致した意思決定を行っていますか。顧客は貴社のAIアルゴリズムによって提供されたデータを信頼していますか。AIが導き出した解を説明できない場合、貴社ブランドへの影響を認識していますか。AIの可能性を最大限引き出すには、AIに付随するリスクを想定し、AIを活用した将来を見据えたシステムを構築しておくことが必要不可欠です。そしてこれらはAIの専門家だけの責任ではありません。CEOをはじめとする経営層、事業部の統括者も念頭に置かなければならない重要なポイントです。

出典:PwC 2019年AI予測

回答者数:1,001人

Q:信頼性、公平性、安定性に優れた責任あるAIシステムの開発と導入に向けて、2019年はどのようなステップを踏む予定ですか?

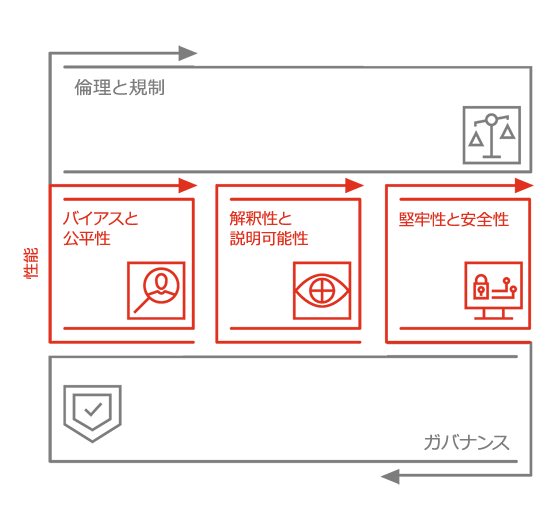

取締役会、顧客、規制当局など、さまざまなステークホルダーから寄せられるAIやデータ利用に関する問い合わせに対し、企業は回答する必要があります。それは、開発から管理状況まで、あらゆる領域に及びます。ただ、回答するだけでは十分ではありません。ガバナンスと規制の遵守を、継続的に証明し続ける必要があります。

PwCは、倫理的かつ説明可能な形を担保しながらAI活用を支援する、説明可能なAI対応に向けたツールキットを提供しています。ツールキットには、カスタマイズ可能なフレームワーク、ツール、そしてプロセスが含まれています。これにより、戦略から実行まで、各社固有のビジネス要件やAI成熟度に沿った支援が可能になります。

PwCは、責任あるAIへの対応状況について、無料診断サイトを開設しています。ぜひお試しください。

質問例

説明可能なAIは、AI活用を検討し始めたばかりでも、また、大規模展開に備える段階であっても、有用です。PwCは、AIを活用した事業支援や変革における確固たる実績とグローバルな専門知識を有しています。これらを基にクライアントのニーズを理解・評価し、各社固有のリスクと課題に対応する戦略の策定から実行まで支援します。

{{item.text}}

{{item.text}}