{{item.title}}

{{item.text}}

{{item.text}}

2020-06-29

居住地、年齢、そして職業に関係なく、私たちは皆、AI(人工知能)技術の台頭による影響を受けています。また、今後もその傾向は続くでしょう。

日本は、少子高齢化[1]から発生する様々な問題に直面しています。中には、日本経済団体連合会(経団連)[2]や内閣府[3]が推進しているSociety 5.0実現の鍵となる、AIを活用した製品やサービスの浸透によってのみ解決できる問題も存在します。Society 5.0の実現は進展しており、自動運転車、脳信号で制御可能なパワードスーツ、そしてIoTおよび画像認識技術を活用した無人店舗は、AIを活用した製品やサービスの好例です。

しかし、AIによる不具合が発生し、それが、重大かつ多大な影響を及ぼすものである場合、Society 5.0の実現は滞る可能性があります。AIに対する信頼低下、そしてAIを活用した製品やサービス導入の減速といった状況も想定されるでしょう。

本レポートでは、AIの不具合によるリスクを最小限に抑えるAIガバナンスの検討、そして構築に向けた、新たな手法を提言しています。「H/O/P/Eフレームワーク」という、ホリスティック(Holistic、すべてのステークホルダーが関与し)かつオープン(Open、ガバナンスプロセスの透明性が担保され)、プロポーショナル(Proportional、潜在リスクとその影響に応じて変化し)、そしてエンドツーエンド(End-to-End、AIを活用した製品やサービスのライフサイクル全段階において継続的)なAIガバナンスの必要性を説き、また、「H/O/P/Eフレームワーク」を適用する方法についても、Society 5.0が目指す日本社会を舞台にした架空のストーリーを基に紹介します。

本レポートは、PwC JapanグループそしてPwC英国、PwC米国それぞれの拠点のAI専門家と、ユーラシア・グループのジオテクノロジー専門家による共著です。 PwCは、自社の業務、そして製品やサービスへのAI導入を目指す、多様な業種の企業を支援しています。また、世界経済フォーラム(The World Economic Forum)や国際連合、そして世界中の政府とも連携し、AIの設計や開発、活用、そして保守のさらなる進展に尽力しています。

本レポートが読者の皆様および皆様の事業の一助となると同時に、「スマート・テック・アプリケーション」 と称する、AIと新興技術を組み合わせた製品やサービスに対する社会からの信頼の構築と強化、そして責任ある、また、倫理的な方法で、AIの力が活用されることに貢献できれば幸いです。

ヤン・ボンデュエル

PwC Japanグループ データ&アナリティクス リーダー

PwCコンサルティング合同会社 パートナー

1 リンダ・グラットン,アンドリュー・スコット,2016. 『LIFE SHIFT』東洋経済新報社.

2日本経済団体連合会,2018.「Society 5.0」 https://www.keidanren.or.jp/policy/society5.0.html

3 内閣府,「Society 5.0」 https://www8.cao.go.jp/cstp/society5_0/

山梨県の農家、ヨシダ・ヒロユキ氏[4]は、果樹園に囲まれた自宅に家族と住み、長年懸命に働いてきた。彼のそれほど多くない収入で、家族を養っていくことは、たやすいことではなかった。ヨシダ氏は、現在92歳。寝たきりで、生活のすべてを妻のミチコに頼りきっている。かつてはひ孫と遊ぶことが大好きだったヨシダ氏だが、体力の衰えとともに次第に引きこもりがちになっていた。ミチコは、夫がこの先、家族と一緒に自宅で生活できないのではないかと心配している。 そんなヨシダ氏が目を輝かせたのは、あるエンジニアの話を聞いた時だった。運動機能障害を持つ人が再び歩行できるように補助をする、意欲的かつこれまでにないパワードスーツのプロトタイプを開発したというのだ。人工知能(AI)を活用したそのパワードスーツは、地形の変化を予測し、個々のユーザー独特の歩き方に適応し、意図した動きに反応して方向を変えることができるという。興味をひかれたヨシダ氏一家は、そのエンジニア、スズキ氏に連絡をとり、ヨシダ氏がプロトタイプの被験者になることに合意した。 最初のテストは成功だった。体格に合うよう数カ月かけて調整されたパワードスーツを装着したヨシダ氏は、数歩、歩くことができたのだ。しかし、3度目のテストに事故が起きてしまった。激しく転んでしまったヨシダ氏は、膝に重いけがを負っただけでなく、肋骨を数本骨折し、結果的に、再び寝たきりになってしまった。後日、この事故についての調査が行われた。 主な原因として、次の3つが考えられた。第一に指摘されたのは、このパワードスーツに搭載されたAIがバランスをとるためのアルゴリズムは、数千時間にわたる学習を屋内で行っていたこと。そしてその被験者は、スポーツや交通事故による障害を持つ100人以上の若いボランティアで、再び歩いたり、走ったり、またスポーツをしたいと望んでいる人たちだったことだ。つまり、ヨシダ氏は、このパワードスーツを着用した初めての高齢者だったのだ。調査の結果、パワードスーツがヨシダ氏の動きに対してあまりにも速く反応しすぎたため、ヨシダ氏が過剰に反応してしまいバランスを崩したことが明らかになった。第二に指摘されたのは、3回目のテスト実施日の、地面の状態だ。当日は、わずかに地面が濡れていたのだが、それは学習したデータの中にはない条件だった。最後に指摘されたのは、濡れた地面を考慮すれば当然慎重であるべきところ、ヨシダ氏がそうではなかったことだ。過去2回のテストでヨシダ氏が自信を持つようになり、以前よりも慎重さを欠いてしまったことも原因のようだった。 |

調査の結果は、開発者のスズキ氏にとって厳しいものだった。スズキ氏が承認済みのロボット開発プロセスに従っていたことは認められたが、パワードスーツに使用されているAIについて、AIガバナンスを適用していなかったことが指摘された。調査結果では、学習データが収集された時の条件(交通事故に遭った若者が、室内で歩いたり走ったりできるようになることを想定)と、ヨシダ氏が実際にテストを行った時の特定の条件(高齢者が、屋外で限られた範囲を歩くことを支援)との差について特に懸念が示され、このことが偏ったデータをAIに学習させたと結論づけた。スズキ氏を支援している投資家たちは、AIがさまざまな環境や条件に適応できることをチェックする基準がなければ、開発の継続には多大なリスクを伴うと感じた。パワードスーツを最終的に製品化する前に、重大な仕様変更、コストの増加、そして開発の遅れを覚悟しなくてはならなくなり、この新しい状況に直面した結果、投資家たちは撤退した。被験者だったヨシダ氏の家族は、ヨシダ氏が次第に家の中を自らの力で動けるようになることを楽しみにしていた。しかし、ヨシダ氏は衰弱した上に負傷し、最後には老人ホームに入ることになってしまった。

この架空のストーリーは、テクノロジーの恩恵を最大化しながら、それに付随するリスクは最小化せよ、という現実世界での重要な問いかけを提示している。これはまさに、「スマート・テック・アプリケーション」 と称する、AIを活用した製品やサービスのメーカーに対する私たちPwCの支援内容に関連するものだ。

AIを活用するだけでなく、新興テクノロジーにAIを組み合わせることで、ビジネスや社会へ与えるインパクトはさらに高まり、価値を提供する。スマート・テック・アプリケーションの多くは今後10年以上にわたって普及が進み、ヨシダ氏のような高齢者を含む数十億もの人々の、より長く、より健康で、より幸せな生活を支援するだろう。一方で、あらゆる革新的なテクノロジーと同様に、スマート・テック・アプリケーション[5]も弊害をもたらす可能性がある。そのため、スマート・テック・アプリケーション、特に、AI技術に対する社会からの信頼を維持するための、優れたガバナンスが重要である。それは今、人々の生活と幸福が危機にさらされているというだけでなく、世界が直面する最大の課題に取り組む上で、安全で活気に満ち、かつ革新的なスマート・テック産業は、我々が大きな期待を寄せることができる希望の1つだからだ[6] 。

本レポートでは、AI、そしてAIを内包するスマート・テック・アプリケーションに対する社会からの信頼を構築かつ強化するための、新しく、また包括的なAIガバナンスの考え方を提示する。私たちは、ホリスティック(すべてのステークホルダーが関与し)かつオープン(ガバナンスプロセスの透明性が担保され)、プロポーショナル(潜在リスクとその影響に応じて変化し)、そしてエンドツーエンド(AIを活用した製品やサービスのライフサイクル全段階において継続的)なAIガバナンスを採用することで、スマート・テック・アプリケーションにおけるAIの故障や誤作動のリスクを最小限に抑えられると信じている。

本レポートは、業務や、新製品・サービスにおけるAI活用に取り組んでいる企業幹部を対象としており、目的は次の2点である。

4 本レポートにおいて、グレーの囲み部分は架空のストーリーであることを示す。

5 本レポートにおける「スマート・テック・アプリケーション」とは、AIと新興テクノロジー、例えばロボティクス、ドローン、ブロックチェーン、3Dプリンター、IoT、AR、VRなどとの組み合わせを指す。これらのテクノロジーはPwCによって「Essential Eight」と定義されている。さらに、スマート・テック・アプリケーションの中でAIについて言及する際は、同アプリケーション内での自律的かつ情報処理機能を持つシステムのことを指す。

6 World Economic Forum, 2020. “The Global Risks Report 2020” https://www.weforum.org/reports/the-global-risks-report-2020 (アクセス日:2020年1月21日)

猛威を振るう山火事や台風、そして世界的な伝染病や暴動――こうした混乱の背景には、気候変動、水資源危機、資源の枯渇、そして人口統計的および社会的な変化が存在していることを裏付ける現象が、毎日のように起きている[7]。これらのグローバルメガトレンドは、人類の幸福、経済成長、そして環境を脅かしている。だがしかし、幸運なことに、テクノロジーにはそれを救える可能性がある。

そしてAI以上に、こうした課題に対する人々、企業、政府による取り組みを支援する技術は、まず存在しない。例えば、AIを活用した製品とサービスは、新薬の開発を促進し[8]、低炭素経済への移行を加速し[9]、退職後や老後の尊厳ある生活を支援する可能性を持っている[10]。経済的利益だけでも莫大なものとなる可能性があり、PwCは、2030年までにAIが世界経済に与える影響は、15.7兆米ドルと推定している[11]。

それでもなお、多くの人々にとって、AIは恐怖と不安を引き起こす存在でもある。「キラーロボット(自律型致死兵器システム)」に関する憶測、自動化がもたらす失業、ディープフェイク(人工知能に基づく人物画像合成)、また顔認識技術によるプライバシー侵害への不安といった懸念は、既にAIの利点とリスクに関する公の議論の一部となっている。

こうした懸念は、理論上のものというだけではない。2018年に米国アリゾナ州で起きたテスト中の自動運転車による歩行者の死亡事故では、他のいくつかの要因とともに、AIの故障が関連しているとされた[12]。2019年10月、雑誌「Science」の記事は、2億人以上にのぼる米国人の治療法の決定に使用されたソフトウェアプログラムが、構造的な人種的偏見を示していると主張した[13]。

現在一般的に人間の介入と判断を必要とするタスクは、AIによってますます自動化されるだろう。しかし、スマート・テック・アプリケーションに含まれるAIから生じるエラーや偏りは、何らかの害を引き起こすまで気付かれないことがある。AIの誤作動がもたらす直接的なコスト以外に、AIの力を活用している主要な技術システムの障害が引き起こす間接的な影響もある。このことは、AI技術に対する社会からの信頼を大幅に損ない、さらには、社会課題の解決に向けたテクノロジーソリューションの採用を減速させかねない。

原子力から遺伝子工学に至るまで、歴史を振り返ると、数多くの新しいテクノロジーが生まれてきた。それらの安全上のリスクや社会への影響に関する懸念が、そうしたテクノロジーの開発や展開を妨げる政治的な反発を引き起こしてきたのも事実である。これらのリスクは、AIにとって特に深刻である。AIは前世代の技術革新よりもはるかに不安定な政治環境の中で成長しており、以前のテクノロジーに比べてより多くの産業や人々に影響を与える可能性を秘めている。近年、AIの多くの側面に対し、社会的かつ政治的な監視がますます強まっている。これには、以下のものが含まれる。

これは、革新を進めるにはリスクの高い環境であることを示唆している。しかし、世界経済にスマート・テック・アプリケーションが適用されるとき、もしAIの実装が不十分であれば、それが引き起こす経済的、心理的、身体的な損害や、さらには人命の犠牲といったリスクが高まってしまう。重大な事案が発生すれば、それを受けて社会的および規制上の反発が高まり、 多くのAIを活用した製品やサービスが築いてきた信頼を損なうことになるだろう。前述のヨシダ氏やスズキ氏のストーリーに見られたように、社会的な反発により、こうした分野への投資が遅れたり、高齢化社会、食糧危機、極度の気象災害といった地球規模の差し迫った課題に対処しうるAIや関連したスマート・テック・アプリケーションの革新が抑制されたりする可能性がある。

それでは、人や社会に害をもたらすリスクを軽減すると同時に、AIや 、スマート・テック・アプリケーションの信頼を確立するにはどうすればよいのか。それは、優れたAIガバナンス、つまりスマート・テック・アプリケーションに取り組む企業やその他の関係者が、データを使用し、欠陥をチェックし、またAIの導入における説明責任を担保するための最良の事例、規則、ガイドラインを用意することである。これこそが、AIガバナンスが重要な理由である。

スマート・テック・アプリケーションは数多くの新興技術分野で絶え間なく進歩しており、差し迫った社会課題に対応できる非常に大きな可能性を持っている。これまでにない分野で、働きながら社会支援もできる機会は、新興技術のコミュニティにとって意欲をかき立てられるものである。高齢者向けの介護ロボットや音声アシスタントは、普及の進むスマート・テック・アプリケーションのほんの一例にすぎない。これらの製品やサービスは、先進国で増え続ける高齢者層のために導入され、その生活の質の向上に貢献している[15]。

しかし、そこには懸念もある。スマート・テック・アプリケーションが引き起こした問題について、広く知られた事例がある[16]。例えば次のようなものだ。

この懸念に加え、最も高度なAI技術革新に付随して発生する「誇大宣伝」という問題もある。ユーザーの心理状態を評価するために設計された感情認識技術が、健全な科学的根拠を欠いている可能性があるという懸念もその1つだ[20]。

幸いにも、AIガバナンスへの包括的なアプローチを重視することで、スマート・テック・アプリケーションにAIを活用している企業は、誤作動や誤使用といったリスクを軽減できる。またユーザーや社会は、有効なスマート・テック・アプリケーションを段階的に採用することにより恩恵を受けることができる。これこそが、AIガバナンスが重要な理由である。

ここ数年、政府、大学、NGO、民間企業は、AIガバナンスのハイレベルなフレームワークとガイドラインの開発を開始し、イノベーションを必要以上に妨げることなく、スマート・テック・アプリケーションに関連するリスクを軽減できるようにしてきた。

こうした取り組みが最も進んでいるのは、間違いなく民間企業においてであり、実際、それぞれの企業内および複数のステークホルダーからなる組織を通じて実施されている。例えばPartnership on AI(AIに関するパートナーシップ)[21]は、Amazon、Facebook、Google、DeepMind、Microsoft、そしてIBMによって2016年後半に設立された。現在では、学術団体、市民組織、企業、非営利団体など100以上のパートナーが参加している。また、主要なテクノロジー企業は企業固有のガイドラインや原則も公開しており、既にAI研究やAIを活用した製品やサービスの開発支援に適用されている。

国際標準化機構(ISO)、国際電気標準会議(IEC)、 IEEE(Institute of Electrical and Electronics Engineers)などの非政府機関[22]は、倫理とガバナンス、両面からの基準を取り入れ、AIの標準に関する独自の概念に取り組んでいる。世界経済フォーラム第4次産業革命センターは世界各地のさまざまな組織のフェローと協力して重要な問題を提起し、最近発表された企業の取締役会向けの人工知能ツールキットのような新しいテクノロジーに向けた実用的なガイダンスを提案している[23]。

AIの周りに規制のガードレールを巡らせようという政府の試みは、均一ではないが、盛んになっている[24]。最も注目すべき最近の取り組みは次のようなものである。

PwCを含む多くの組織は、AIガバナンスの実践的な実装を促進するAIガバナンスの手法とツールを開発してきた。これには、AIモデルとデータに潜む偏りの自動チェック、AIモデルの堅牢性の評価、AI アルゴリズムの結果を解釈しやすくするための新しいアプローチが含まれる。

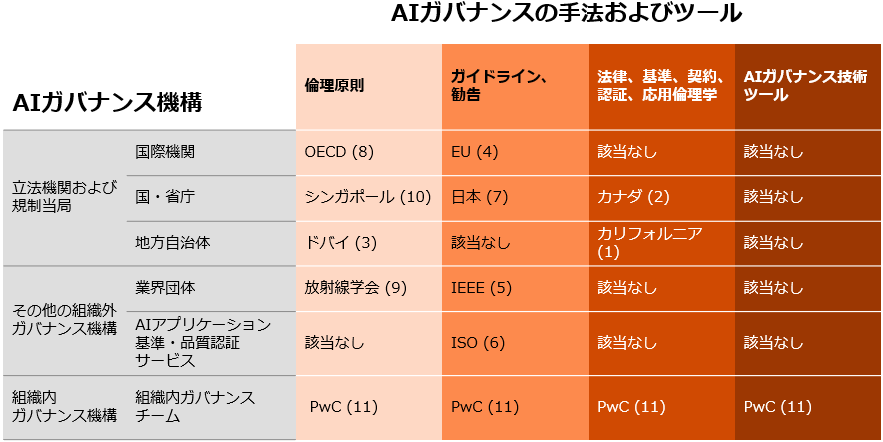

本レポートでは、AIの倫理面とガバナンス面を考慮した最も重要な取り組みのいくつかを選定した(図表1参照)。倫理原則の理解から特定のAIガバナンス技術ツールの適用に至るまで、有用なガイダンスを求める組織が利用可能なさまざまな手法とツールをまとめたもので、出所は、国連やEUといった国際的組織、企業の内部監査チームなど多岐にわたる。こうした分野では多くの取り組みが行われているが、意義のある貢献が次々に起こるため、遅れをとらずについていくことは難しい。数カ月前、スタンフォード大学の行動科学先端研究センター(CASBS)とŞerife Wong氏のパートナーシップであるFluxus Landscapeによって、AI倫理とガバナンスへの貢献を示す最新の視覚的表現が示された。これはコラボレーション・プラットフォームの形[32]で、AIガバナンス分野におけるイノベーションのスピードを説明している。

(1) カリフォルニア AB-2269 Personal rights: automated decision systems, https://leginfo.legislature.ca.gov/faces/billTextClient.xhtml?bill_id=201920200AB2269 (2) カナダ Canada’s CIO Strategy Council publishes nationalAIstandards (3) ドバイ Artificial Intelligence Principles & Ethics https://www.smartdubai.ae/initiatives/ai-principles-ethics (4) 欧州連合 White Paper on Artificial Intelligence: a European approach to excellence and trust, The European Commission 2020 (5) IEEE The IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems (6) ISO ISO/IEC JTC 1/SC 42 https://www.iso.org/committee/6794475.html (7) 日本 Contract Guidelines on Utilization ofAIand Data, Ministry of Economy, Trade and Industry of Japan 2018 https://www.meti.go.jp/english/press/2019/0404_001.html (8) OECD Forty-two countries adopt new OECD Principles on Artificial Intelligence, OECD 2019 https://www.oecd.org/science/forty-two-countries-adopt-new-oecd-principles-on-artificial-intelligence.html (9) 放射線学会 Ethics of Artificial Intelligence in Radiology: Summary of the Joint European and North American Multisociety Statement https://pubs.rsna.org/doi/10.1148/radiol.2019191586 (10) シンガポール Singapore ModelAIGovernance Framework Second Edition https://www.sgpc.gov.sg/sgpcmedia/media_releases/imda/press_release/P-20200122-2/attachment/Singapore%20Model%20AI%20Governance%20Framework%20Second%20Edition%20-%20Framework.pdf[PDF 1,295KB] |

PwC ResponsibleAIToolkit https://www.pwc.com/rai

*アルファベット順

これまでのところ、多くのAIガバナンスの手法とツールは、AIを活用した製品やサービス(原則、ガイドライン、技術的ツール)のメーカーとデータの提供者(主にGDPRや同様の法的フレームワーク、また一部の技術的ツール)向けに設計されてきた。AIによって強化されたスマート・テック・アプリケーションの複雑性が増し、またその導入が加速していることを考慮すると、今こそ、より包括的で実用的なAIガバナンスを実現する好機である。AIを活用した製品やサービスのメーカーとデータの提供者にとどまらず、スマート・テック・アプリケーションを取り巻くすべてのステークホルダーを関与させることができれば、AI設計者やデータの専門家だけに頼るよりも良い結果を生むであろう。これこそが、AIガバナンスが重要な理由である。

7 World Economic Forum, 2020. “The Global Risks Report 2020” https://www.weforum.org/reports/the-global-risks-report-2020(アクセス日:2020年1月21日)

8 PwC, 2017. “AI and robotics are transforming healthcare” https://www.pwc.com/gx/en/industries/healthcare/publications/ai-robotics-new-health/transforming-healthcare.html (アクセス日:2020年1月22日)

9 PwC, 2019. “Harnessing artificial intelligence for the Earth” https://www.pwc.com/gx/en/services/sustainability/publications/ai-for-the-earth.html (アクセス日:2020年1月22日)

10 The Government of Japan, 2017. “Realizing Society 5.0” https://www.japan.go.jp/abenomics/_userdata/abenomics/pdf/society_5.0.pdf[PDF 3,267KB] (アクセス日:2020年1月22日)

11 PwC, 2017. “Sizing the Prize: What’s the real value of AI for your business and how can you capitalise?” https://www.pwc.com/gx/en/issues/analytics/assets/pwc-ai-analysis-sizing-the-prize-report.pdf[PDF 13,945KB] (アクセス日:2020年1月24日)

12 Kelsey Piper, 2020. “It’s 2020. Where are our self-driving cars?”, Vox. https://www.vox.com/future-perfect/2020/2/14/21063487/self-driving-cars-autonomous-vehicles-waymo-cruise-uber (アクセス日:2020年2月15日)

13 Ziad Obermeyer, Brian Powers, Christine Vogeli, and Sendhil Mullainathan, 2019. “Dissecting racial bias in an algorithm used to manage the health of populations”, Science 25 Oct 2019: Vol. 366, Issue 6464, pp.447-453. https://science.sciencemag.org/content/366/6464/447

14 ICT とは、Information and Communications Technologyの略である。

15 Thisanka Siripala, 2019. “Japan's robot revolution in senior care”, The Japan Times. https://www.japantimes.co.jp/opinion/2018/06/09/commentary/japan-commentary/japans-robot-revolution-senior-care/ (アクセス日:2020年2月2日)

16 Remco Zwetsloot, Allan Dafoe, 2019. “Thinking About Risks From AI: Accidents, Misuse and Structure”, Lawfare, 11 February, 2019. https://www.lawfareblog.com/thinking-about-risks-ai-accidents-misuse-and-structure (アクセス日:2020年2月2日)

17 Jane Wakefield, 2016. “Robot runs over toddler in shopping centre”, BBC News, 14 July, 2016. https://www.bbc.com/news/technology-36793790 (アクセス日:2020年2月2日)

18 Rob Lever, 2019. “More privacy missteps cast cloud over voice-activated digital assistants”, The Japan Times, 3 AUG, 2019. https://www.japantimes.co.jp/news/2019/08/03/business/tech/privacy-missteps-cast-cloud-voice-activated-digital-assistants/ (アクセス日:2020年2月15日)

19 PwC, 2018. “Will robots really steal our jobs?” https://www.pwc.com/hu/hu/kiadvanyok/assets/pdf/impact_of_automation_on_jobs.pdf[PDF 917KB] (アクセス日:2020年1月31日)

20 Crawford, Kate, Roel Dobbe, Theodora Dryer, Genevieve Fried, Ben Green, Elizabeth Kaziunas, Amba Kak, Varoon Mathur, Erin McElroy, Andrea Nill Sánchez, Deborah Raji, Joy Lisi Rankin, Rashida, Richardson, Jason Schultz, Sarah Myers West, and Meredith Whittaker, 2019. “AI Now 2019 Report”, New York: AI Now Institute. https://ainowinstitute.org/AI_Now_2019_Report.html . (アクセス日:2020年1月20日)

21 Partnership on AI, https://www.partnershiponai.org/about/ (アクセス日:2020年1月28日)

22 IEEE, “IEEE Global Initiative on Ethics of Autonomous and Intelligent Systems” https://standards.ieee.org/industry-connections/ec/autonomous-systems.html (アクセス日:2020年1月27日)

23 World Economic Forum, 2020. “Artificial Intelligence Toolkit Helps Companies Protect Society and Their Business” https://www.weforum.org/press/2020/01/artificial-intelligence-toolkit-helps-companies-protect-society-and-their-business/(アクセス日:2020年2月5日)

24 Oxford Insights and the International Development Research Centre, 2019. “Government AI Readiness Index” https://ai4d.ai/index2019/(アクセス日:2020年1月23日)

25 Masumi Koizumi, 2019. “G20 ministers agree on guiding principles for using artificial intelligence”, The Japan Times, 8 Jun, 2019. https://www.japantimes.co.jp/news/2019/06/08/business/g20-ministers-kick-talks-trade-digital-economy-ibaraki-prefecture/#.Xiqg0cgzZPY (アクセス日:2020年1月23日)

26 OECD, 2019. “Forty-two countries adopt new OECD Principles on Artificial Intelligence” https://www.oecd.org/science/forty-two-countries-adopt-new-oecd-principles-on-artificial-intelligence.htm (アクセス日:2020年1月23日)

27 Janosch Delcker 2019. "POLITICO AI: Decoded: Europe’s AI cacophony — Human rights enter AI debate — Who’s liable for AI harms?", Politico, 12 Apr, 2019. https://www.politico.eu/newsletter/ai-decoded/politico-ai-decoded-europes-ai-cacophony-human-rights-enter-ai-debate-whos-liable-for-ai-harms/ (アクセス日:2020年1月21日)

28 The European Commission, 2020. “White Paper on Artificial Intelligence: a European approach to excellence and trust” https://ec.europa.eu/info/files/white-paper-artificial-intelligence-european-approach-excellence-and-trust_en (アクセス日:2020年2月22日)

29 PwC, “General Data Protection Regulation (GDPR)” https://www.pwc.com/gx/en/issues/regulation/general-data-protection-regulation.html (アクセス日:2020 年 1 月 24 日)

30 Ministry of Economy, Trade and Industry of Japan, 2018. “Contract Guidelines on Utilization of AI and Data” https://www.meti.go.jp/english/press/2019/0404_001.html (アクセス日:2020年1月23日)

31 UK Government, 2019. “Draft Guidelines for AI procurement” https://www.gov.uk/government/publications/draft-guidelines-for-ai-procurement (アクセス日:2020年1月23日)

32 Şerife Wong, CASBS, 2019. AI ethics and governance map platform https://icarus.kumu.io/fluxus-landscape (アクセス日:2020年1月27日)

このセクションでは、ホリスティック(すべてのステークホルダーが関与し)かつオープン(ガバナンスプロセスの透明性が担保され)、プロポーショナル(潜在リスクとその影響に応じて変化し)、そしてエンドツーエンド(AIを活用した製品やサービスのライフサイクル全段階において継続的)なAIガバナンスを検討する新しい方法を紹介する。

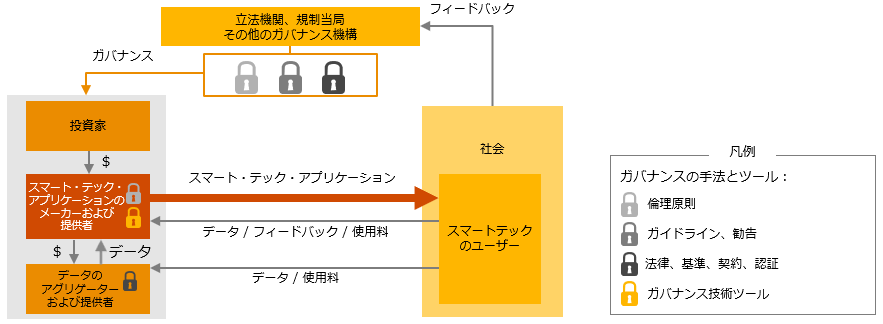

ホリスティックAIガバナンスのプロセスには、AIを活用したスマート・テック・アプリケーションの設計、開発、利用、保守に関わるすべてのステークホルダーが関与する。

スマート・テック・アプリケーションの設計、開発、利用、保守のプロセスには、多くのステークホルダーが貢献している。

投資家: 資金を提供

AI プラットフォームのプロバイダーを含むスマート・テック・アプリケーションのメーカーおよび販売者: 労働力と資金を提供

データのアグリゲーターおよび提供者: データ、労働力、資金を提供

スマート・テック・アプリケーションのユーザー: データとフィードバックを提供。多くの場合、使用料を支払う

立法機関、規制当局、およびガバナンス機関: ガイダンスを定め、管理を行う

国民・市民: フィードバックを提供

すべてのステークホルダーは、直接的または間接的に、市場に投入されたスマート・テック・アプリケーションに対して影響を与えるか、またはその影響を受ける。

AI ガバナンスに関する議論の多くは、データの使用とAIアルゴリズムの開発を主題にしており、データアグリゲーター、AI設計者、および開発者の責任に焦点を当てている。

スマート・テック・アプリケーションの開発と導入を成功させるにはまず、正確で目的に合った、完全もしくはできるだけ偏りのないデータセットから適切なデータを使うべきであることはよく知られている。次にアルゴリズムを開発し、学習させる必要がある。そのアルゴリズムは、理想的には、アルゴリズムが導き出す結論を信頼しなくてはならない個人や組織に対して、その働きを十分に説明可能なものであることが望ましい。

スマート・テック・アプリケーションの成功に対するその他のステークホルダーの貢献は、あまり議論されていない。私たちは「成功」を、 (1) スマート・テック・アプリケーションの故障、誤作動と悪用を回避すること、および (2) これらのアプリケーションに対する人々の信頼の構築に役立つこと、と定義している。

図表2は、ステークホルダーの間の相互作用およびそれらが授受するもの(データ、フィードバック、スマート・テック・アプリケーション、ガバナンス、資金)を示している。図中の鍵のアイコンは、スマート・テック・アプリケーションの設計、開発、利用、保守に通常適用されるAIガバナンスの手法とツールの種類を示している。

すべてのステークホルダーが自分の役割を果たし、スマート・テック・アプリケーションの設計、開発、利用、保守という共通の目標を共有して、AIの故障を回避し、スマート・テック・アプリケーションに対する社会の信頼を築くことができれば、AIがポジティブな影響を与える可能性は高くなる。

私たちが推奨するのは、AIガバナンスの範囲の再定義だ。これにより、スマート・テック・アプリケーションの設計、開発、使用、保守に関わるすべてのステークホルダーが、各自の責任、実行すべきAIガバナンス、それを実行すべき時期と方法を十分に認識できるようにするためである。

スマート・テック・アプリケーションのリスクを軽減し、長期的な信頼を構築するためには、ステークホルダー間の協調的な努力が不可欠である。将来的には、ステークホルダーの責任に関する特定の基準と規制が統合されていくと予想される。その目的は、責任と対立する役割のギャップをできる限り少なくするためであろう。それまでの間、ステークホルダーは、急増している評価ツールを頼りにできる。同様の評価ツールは、PwCもResponsible AI(責任あるAI)に向けたツールキット用に開発している。

AIガバナンスの全体像を把握することにより、スマート・テック・アプリケーションに関与するすべてのステークホルダーが実施したガバナンスのレビューが容易になる。

ホリスティックAIガバナンスの視点を採り入れることにより、スマート・テック・アプリケーションの改善や、適切なルール、ガイダンス、法律の策定には、ユーザーや一般市民からの積極的なフィードバックが必要であることが明らかになる。例えば、データのプライバシーや個人の選択権が重視されるようになるには、長い時間を要した。ごく最近でも、一部の有名な音声アシスタントが引き起こしたデータプライバシーの問題について、もし一般市民が懸念を表明していなければ、データ収集を止めさせる選択はなかっただろう。仮に対策や法律を適切に早期に整備していれば、現在のテクノロジーの反発を最小限に抑えたり遅らせたりした可能性があると主張することもできるだろう。

投資家、特に初期のVC(ベンチャーキャピタル)資金調達ラウンドの投資家は、資金提供先の企業にさまざまなレベルで影響を与える力を持っている。例えばここ数年、財務上の利益とともに倫理的な行動を優先するための措置を講じる投資家も存在しており、スタートアップ企業の経営者が下した決定の一部を修正することに役立った[33]。

33 Sandra Goh and Jack Loveridge, 2019. “Bankrolling Ethics: Tech Investors have a Responsibility to Protect Democracy?”, Epicenter, Harvard University, August 22, 2019. https://epicenter.wcfia.harvard.edu/blog/bankrolling-ethics-do-tech-investors-have-responsibility-protect-democracy (アクセス日:2020年2月3日)

オープンAIガバナンスのプロセスは、AIガバナンスをステークホルダーに対して透明性を高めることだ。これは、AI自体がステークホルダーに見えるようになるという意味ではない。

前項において、ステークホルダーの全体像を把握することで、AIを活用したスマート・テック・アプリケーションの導入を確実に成功させるためのステークホルダーの責任を特定できると示した。全体的な視点により、すべての責任が果たされているか、また埋めるべきガバナンスのギャップがあるかといった点も、より簡単に確認できるようになる。例えば、「フィードバックを収集するためのユーザー組織はあるのか」、「そのユーザー組織は、公正でバランスのとれたフィードバックを提供しているか」「スマート・テック・アプリケーションの販売者はフィードバックに対応しているのか」「ガバナンスのギャップが迅速に解消されていることを誰が確認しているのか」「解決されていない場合は誰が責任を負うのか」「コンプライアンスと責任分担の動機付けのために、どのようなプロセスが導入されているのか」「違反者を従わせる救済策は必要なのか」――このような視点で、確認することができるのだ。

オープンAIガバナンスで必要となるのは、開発を統括する企業やチームが日々の業務を遂行しながら、AIガバナンスへの監視の強化に慣れていくことである。つまり、個々の目標を持つ大勢のステークホルダーとともに、新しいスマート・テック・アプリケーションの開発を行うのだ。オープンガバナンスという状況でステークホルダーとの間に発生しうる対立を仲裁するには、特に、コミュニケーションと仲裁の面において新しいプロセスとスキルが必要となる。そこには、開発を統括する企業やチームが開発に集中できるようにするための独立した認証担当者と、この新しい状況に専門知識を導入していくための専門の認証担当者の役割が存在するだろう。

大勢のステークホルダーとともに、新しいスマート・テック・アプリケーションの開発を行う「AIガバナンスコラボレーション」の実現に際しては、2つのモデルが開発されている。1つ目のモデルは分散型である。AI製品の設計、開発、利用、保守に関わる多くのステークホルダーが、個々に実施したガバナンスの手順を関係者に共有することを自発的に決定するのである。このモデルでは、ステークホルダーは、個々のステークホルダーから寄せられるAIガバナンスリスクの総計を共有することになる。

実際には、データプロバイダーはAI開発者と協力し、データの偏りや非対称性がAIからの出力の誤りや偏りにつながる可能性をチェックするだろう。分散型モデルでは、商業ベンチャーの中で現在実践されているものよりも深いコラボレーションの共有や、おそらくより複雑な法的契約が必要になる。こうしたより緊密なコラボレーションにより、データプロバイダーやAI開発者は、初期に見られるデータの不備を解決するために補完的なデータセットを追加するなど、共通するリスクへの解決策を迅速に見つけられるようになるだろう。

このモデルは、ステークホルダーのサイズとリスクプロファイルが類似している場合、より魅力的になる。このような分散型モデルに付随するAIガバナンス全体の強みは、鎖の強さは一番弱いつなぎ目で決まるという「ザ・ウィーケスト・リンク」の考え方のように、その最も弱い要素に等しくなる。私たちはステークホルダーが自分自身のAIガバナンスだけでなく、ガバナンス全体のうちすべての人が共有している部分にも注意を払うようになることを期待するであろう。

2 つ目のモデルは集中型である。ステークホルダーのサイズとリスクを取れる能力が大きく異なる場合に該当するもので、大規模な開発を統括する企業やチームが小規模な企業や下請業者のネットワークとともに作業をする際などに発生する可能性が高い。この場合、開発を統括する企業やチームはリスク全体に対しての責任を負う。そして、各小規模な企業はAIガバナンスのうち自社の分担にのみ集中する。開発を統括する企業やチームは、小規模な企業や下請業者のガバナンスに関してデューデリジェンスを実施するインセンティブを持っており、それゆえに各企業からの透明性が求められる。

政府や規制当局が、AIガバナンスの度重なる失敗によりスマート・テック・アプリケーションに対する社会の信頼が揺らぐことを、ますます懸念する可能性も考えられる。この信頼性の低さは、高齢化や生産性といった社会課題に対する新しい技術的解決策の採用に影響を及ぼしている。そこには、規制当局がスマート・テック・アプリケーションのステークホルダーに対して、AI ガバナンスプログラムとその進捗状況を公開し共有するよう求めてくるリスクがある。このモデルが、世界中の技術革新者から歓迎されるような状況は考えにくい。しかしAIガバナンスの失敗が続けば、政府がこのモデルを不本意ながら特定の分野に課すという選択肢もありうる。

真のオープンAIガバナンスの実現には、ユーザーや規制当局の積極的関与が必要となる。恐らくは、オープンプラットフォームを使用したものになるだろう。その段階に到達しているとは感じられないが、信頼できるデータや付属ドキュメントを保存、交換、販売するための共有プラットフォーム実装に向けた取り組みはいくつか存在している。これらはデータトラストと呼ばれる[34]。

34 Geoff Mulgan, and Vincent Straub, 2019. “The new ecosystem of trust”, Nesta. https://www.nesta.org.uk/blog/new-ecosystem-trust/ (アクセス日:2020年1月29日)

プロポーショナルな、あるいは目的に合ったAIガバナンスプロセスでは、技術的な複雑さと、AIを活用したスマート・テック・アプリケーションの誤作動や故障による潜在的な影響の大きさに応じて、徹底的に変化するガバナンス対策が推奨される。

スマート・テック・アプリケーションを駆動するAIは、実証済みのものから、画期的で複雑なものまで多岐にわたる。アプリケーションの文脈に応じて、潜在的な誤作動の影響は、致命的なものから無害なものまで幅広い。例えば医療用AIによる誤診は、適確でないターゲット設定の個人向け広告を生成するアルゴリズムよりも、はるかに大きな影響を及ぼす可能性がある。AIガバナンスの深さと広さは、特定のスマート・テック・アプリケーションのAIの複雑さと、その誤作動や故障が引き起こす潜在的な影響に依存すると私たちは考える。

ショッピングサイトのための次世代のショッピング推奨アルゴリズムについて考えてみよう。ユーザーを認証するために顔認識技術を使用し、その情報を基にオンライン決済システムへの直接アクセスを促す。またついには、顔の表情と、タイピングの速度やカーソルの残像といった入力情報とを組み合わせて分析することで顧客の感情を特定・予測し、表示された製品の満足度の測定や、推奨する製品のセットの絞り込みまで可能になるだろう。

すべてがうまく機能すれば、ユーザーの個人データ(顔の表情、タイピングの速度、カーソルの残像)を使用し、ショッピングサイトはユーザーが無意識に望んでいた商品へと誘導するという、明快で実体のある利点を提供できる。

ただし、高度な表情認識AI技術を使うことには、倫理的な懸念を生じる可能性もある。それは個人データと、中国以外ではまだ一般の国民・市民を対象にテストされていない複雑なAIを活用した新技術と、組み合わせることになるからである。何百万人ものオンライン購買客に影響を与えうるAIを活用した新しいアルゴリズムは、厳格なガバナンスアプローチに従う必要がある。このアプローチには、AIガバナンスの適用が徹底されていることを証明する、独立した監督機関が関与することになるだろう。このような事例のAIガバナンスでは、テクノロジーの導入前に潜在的なリスクを精査し、市場に投入された後はユーザーのフィードバックと社会的なフィードバックを監視する方法を提供するべきである。

AIガバナンスの比例性は、ドイツのデータ倫理委員会からの提案に沿っている。最近では、影響の大きさに基づいてアルゴリズムの意思決定システムにさまざまな制御を適用することを推奨しており、これには、5段階の潜在的な影響評価尺度が用いられる[35]。

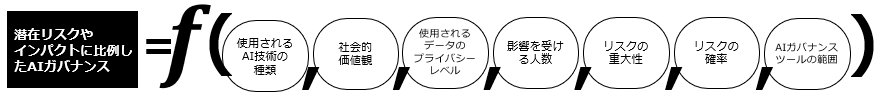

スマート・テック・アプリケーションと各ステークホルダーのために採用されるAIガバナンスは、主に次の7つの要因に依存していると私たちは考える。

1. 使用されるAI技術の種類

スマート・テック・アプリケーションが既に市場でテストされ、ベストプラクティスが確立されている場合、ガバナンスは公式ではなく非公式なものになりうる。AI技術が画期的で、説明可能でない結果をもたらす場合は、包括的なガバナンスアプローチが必要となる。

結果を説明したり、または結果がどのように生成されたかをチェックしたりする方法は現在ほぼ存在しない。そのため、複雑なディープラーニングソリューションにとっては、課題となる可能性がある。

2. 社会的価値観

ガバナンスは、社会的価値観や特定の社会における行動規範の影響を受ける。社会的価値観は、「個人対国家」「規制対革新」「プライバシー対カスタマイズまたは安全性」「透明性対脆弱性」といった倫理的なトレードオフに関して、社会がどの立場をとるかを決定する[36]。

中国では、顔認識を使った決済システムが広がっており、数年後には一般化される可能性がある[37]。この進化は、より迅速で簡単な支払い(電話やカードが不要)のメリットを得るためには、自分の顔の画像を中央データベースに保存することを中国の人々はいとわないということを示しているのかもしれない。

EU諸国では、政府が個人データのプライバシー保護を最重要視している。EUと一部加盟国の規制当局は、一部の用途において顔認識の使用制限を検討している[38]。

ある社会が倫理的なトレードオフに対してとる立場によって、特定のスマート・テック・アプリケーションに適用すべきAIガバナンスの種類が決まる。それはもちろん、AIの開発者、販売者、見込み客の所在地に依存する。これにより、スマート・テック・アプリケーションはますます多国籍なコラボレーションの結果として生み出されるようになり、問題はさらに複雑化する。

3. 使用されるデータのプライバシーレベル

スマート・テック・アプリケーションが、医療記録や、公共の場所において監視目的で記録された人々の顔画像といった機密性の高い個人データを使用する場合、データ処理に関するより厳格な制御が必要となる。

例えば最近、ロンドン警察がキングズクロス駅のセキュリティカメラで撮影した人々の顔画像を、公衆に通知せずに顔認識システムで使用するために共有していたことが明るみに出た[39]。この事件により、警察はキングズクロス当局とデータ共有契約を交渉し、その後の監視技術の利用を管理するようになった。2020年1月下旬、ロンドン警視庁は市内の特定の場所において、ライブ・フェイシャル・レコグニション(LFR)テクノロジーの運用を開始すると発表した。ロンドン警視庁はプレスリリースにおいて、テクノロジーを配置する条件と、人々のプライバシーを保護する取り組みを強調した[40]。

英国以外でも、EUは、EU市民のプライバシーを保護するためにGDPR法を制定している。また、米国ではカリフォルニア州が州内の消費者を対象により厳格なプライバシー管理を行う法律の制定が最終段階を迎えている[41]。

4. 影響を受ける人数

Amazonのショッピング推奨アルゴリズムなど、一部のスマート・テック・アプリケーションは既に数百万人の人々に使用されている。一方で、建設会社や採掘会社が、日常業務や必要な機器の量を予測するために利用するドローンの物体認識システムなどは、使用している人数も影響を受ける人数もわずかだろう。ロサンゼルス市警察が「予測的な治安維持」のために使用しているAIアルゴリズムはこの両者の中間にあたり、数千人が影響を受ける[42]。

AIガバナンスの基準は、誤作動や故障の影響を受ける可能性のある人の数に応じて変える必要がある。

しかし残念ながら、現実の世界はそれほど単純ではない。多くのスマート・テック・アプリケーションは複雑な経過をたどる。ある目的を念頭に開発され、当初はターゲットユーザーがごく少数のこともある。それが時間とともに進化する中で、いつの間にか多くのユーザーを集めることになる。そのため、誤作動や故障の影響を受ける人の数は、スマート・テック・アプリケーションの存続期間中に指数関数的に増加する可能性があり、このことは適用されるAIガバナンスの種類にも影響を及ぼす。

5. リスクの重大性

AIを活用した製品やサービスが使用される機会は飛躍的に増えている。一方で、財務や評判、さらには人々の健康や幸福に与えうる影響やリスクの大きさを忘れてはならない。

例えば、被告の再犯の可能性を予測するために米国の裁判所で使われている、AIの判決決定支援ツールCOMPASが挙げられる[43]。裁判官はCOMPASを使用し、再犯の判断を下すのである。このCOMPASには再犯予測において人種的な偏りがあり[44]、ランダムに選ばれた20人のインターネットユーザーの意見の平均と変わらないことが示されている。

アルゴリズムの故障の可能性を考慮すると、こうしたツールの今後の開発に適用されるガバナンスは、オーディオ・ストリーミング・サービスのウェブサイトや、携帯端末用アプリケーションの楽曲の推奨機能の公開に適用されるガバナンスより、厳格なものでなくてはならない。

PwCは、クライアント業務において、AIを活用した製品やサービスのリスクについて6つのカテゴリをレビューする。6つのカテゴリとは、性能、安全性、制御、経済、社会的、倫理である[45]。

リスク分析やマルチ属性ユーティリティ理論など、さまざまな定性的および定量的手法を駆使し、特定のAIを活用した製品やサービスの性能リスクを、いくつかの次元(コスト、健康、評判など)で評価することができる[46]。

6. リスクの確率

いくつかの定性的および定量的手法を使用し、特定のリスクの可能性を評価することができる。測定可能なリスクに対しては、統計は分かりやすい方法である。観察不可能なリスクに対しては、主観的確率評価がよく知られている[47]。さまざまな方法で測定された複数のAI技術のリスクを比較する際、方法論的な問題が生じる。

7. AIガバナンスツールの範囲

AIガバナンスの現状についてこれまでに述べてきた。AIガバナンスの手法やツールは既に数多く存在し、毎年さらに多くのものが開発されている。利用可能なAIガバナンスの手法とツールの適切な組み合わせの選択は、現時点での、あるいは将来予測される組織内部のスキルと組織外部からの圧力に左右される。

より強力な統制を求める社会からの圧力が高まり続けているため、規制当局に対しては、さらに協力を深めると同時に、厳格な勧告や法律を制定することにより、要求に応えることを期待している。これらは無視できないものになるだろう。これまでのところ、データやAIの誤作動が偶発的または人間の悪意による結果であった場合、財務や評判に与える実質的、長期的な影響はほとんどなかった。しかし、この状況は変化すると予想される。現在そうであるように、スマート・テック・アプリケーションの開発者は、まずユーザー中心のAIガバナンスへ、次に社会中心のAIガバナンスへの迅速な移行を余儀なくされるだろう。

また規制当局も、より実用的なアプローチを進化させ、採用する必要がある。規制を実施することが困難な場合、規制当局は、規制をより簡単に適用できるようにしたり、代替案を提示したりすることを望むかもしれない[48]。例えば、リスクの高いケースに対してはスマート・テック・アプリケーションの品質保証が必要になる可能性がある。しかし、AIの設計やデータの脆弱性を特定するための「メタ」AIエンジンの開発はまだ実現できそうにない。代わりに、スマート・テック・アプリケーションの開発過程の全段階で責任あるAIガバナンスに向けた対策が適用されるようにすること、また、例えばさまざまなデータセットを用いて、境界条件の下でスマート・テック・アプリケーションのテストを行うことを考慮すべきである。

これまでに説明した7つの要因は、図表3の概念式に要約できる。この式は、スマート・テック・アプリケーションの設計、開発、利用、保守におけるステークホルダーが、誤作動や故障のリスクを最小限に抑え、信頼を構築するために必要なAIガバナンスを定義するための簡単な方法を示している。特定のスマート・テック・アプリケーションだけでなく、将来のすべてのスマート・テック・アプリケーションにおいても、一度に、1つのレイヤーで実行可能である。

また、この式は、AIガバナンスが時間の経過とともにどう変化するか確認するためにも役立つ。テクノロジー、社会的価値観、利用可能なガバナンスの手法やツールの範囲は、時間とともに変化するからである。

35 Algorithm Watch, 2019. “Germany’s data ethics commission releases 75 recommendations with EU-wide application in mind” https://algorithmwatch.org/en/germanys-data-ethics-commission-releases-75-recommendations-with-eu-wide-application-in-mind/ (アクセス日:2020年2月4日)

36 PwC, 2019. “Gaining National Competitive Advantage through Artificial Intelligence (AI)” https://www.pwc.lu/en/technology/gaining-national-competitive-advantage-through-ai.html (アクセス日:2020年1月26日)

37 The Guardian, 2019. “Smile-to-pay: Chinese shoppers turn to facial payment technology”, 4 Sep, 2019. https://www.theguardian.com/world/2019/sep/04/smile-to-pay-chinese-shoppers-turn-to-facial-payment-technology (アクセス日:2020年2月4日)

38 BBC, 2017. “Google DeepMind NHS app test broke UK privacy law”, 3 July, 2017. https://www.bbc.co.uk/news/technology-40483202 (アクセス日:2020年2月4日)

39 Dan Sabbagh, 2019. “Facial recognition row: police gave King's Cross owner images of seven people”, The Guardian, 4 Oct, 2019. https://www.theguardian.com/technology/2019/oct/04/facial-recognition-row-police-gave-kings-cross-owner-images-seven-people (アクセス日:2020年2月4日)

40 Metropolitan Police, 2020. “Met begins operational use of Live Facial Recognition (LFR) technology” http://news.met.police.uk/news/met-begins-operational-use-of-live-facial-recognition-lfr-technology-392451 (アクセス日:2020年1月31日)

41 California State Legislature, 2018. “AB-375 Privacy: personal information: businesses.” https://leginfo.legislature.ca.gov/faces/billTextClient.xhtml?bill_id=201720180AB375 (アクセス日:2020年1月29日)

42 Issie Lapowsky, 2019. “How the LAPD Uses Data to Predicted Crime”, Wired, 22 May, 2019. https://www.wired.com/story/los-angeles-police-department-predictive-policing/ (アクセス日:2020年1月24日)

43 Ed Yong, 2018. “A Popular Algorithm Is No Better at Predicting Crimes Than Random People”, The Atlantic, 17 Jan, 2018. https://www.theatlantic.com/technology/archive/2018/01/equivant-compas-algorithm/550646/ (アクセス日:2020年1月24日)

44 Julia Dressel and Hany Farid, 2018. “The accuracy, fairness, and limits of predicting recidivism”, Science Advances, 17 Jan 2018, Vol.4, no.1. https://advances.sciencemag.org/content/4/1/eaao5580 (アクセス日:2020年1月28日)

45 PwC, 2019. “Responsible AI Toolkit” https://www.pwc.com/rai (アクセス日:2020年1月23日)

46 R. L. Keeney and H. Raiffa, 1976. Decisions with Multiple Objectives, Wiley.

47 Ronald A. Howard, Ali E. Abbas, 2015. Foundations of Decision Analysis, Global Edition, Pearson.

48 Tom Simonite, and Gregory Barber, 2019. “It's Hard to Ban Facial Recognition Tech in the iPhone Era”, Wired, 19 Dec, 2019. https://www.wired.com/story/hard-ban-facial-recognition-tech-iphone/ (アクセス日:2020年1月29日)

AIガバナンスの取り組みの多くは、利用開始前のスマート・テック・アプリケーションを対象としている。完全なAIガバナンスを実現するには、AIを活用した製品やサービスの設計段階からプロセスを開始し、使用終了まで継続しなくてはならない。ただし、スマート・テック・アプリケーションの目的、焦点、およびユーザー層が時間の経過とともに変化しなければ、その必要はないかもしれない。

しかし、特定の機能のために設計され、少数のユーザーだけでテストされるスマート・テック・アプリケーションは増え続けている。誤作動のリスクは含まれており、潜在的な誤作動による影響の予測は楽観的である。だが実際は、アジャイル開発の登場により、現実は大きく異なることが多い。ユーザー数の増加に応じて機能を強化した後継バージョンがリリースされるからだ。例えば最近のスマートフォン用アプリケーションでは、相手の顔写真を「将来の顔」に変換して表示したり、年齢を重ねた際どう見えるのか表示したりするものがある。当初は比較的小規模なユーザーの間で楽しむことが目的だったが、すぐに大変な人気が出たことで、多くの顔写真を収集する目的に疑問を投げかけられるようになった。

一部のスマート・テック・アプリケーションのユーザーベースの拡大は驚くほどの速さであり、数日から数週間のうちに大幅に増加することがある。これに対処するには、通常なら月または年単位のサイクルで機能しているAIガバナンスのフレームワークとプロセスを、迅速に対応させなくてはならない。AI ガバナンスをスマート・テック・アプリケーションの進化の速度に適応させることは、特に消費者領域での課題となっている。特にエンドツーエンドAIガバナンスは手続き上の課題を伴い、また自動化ツールの開発を必要とする。

こうした課題はあるにせよ、スマート・テック・アプリケーションの誤作動や故障の影響を受ける可能性のある人数の増加に応じて適切な制御を実行するには、エンドツーエンドAIガバナンスが唯一の効果的な方法となるだろう。

このセクションの結論として、私たちは、AIガバナンスがホリスティックかつオープン、プロポーショナル、そしてエンドツーエンドであるときのみ、永続的に成功すると確信するに至った。そのためにはより正式なプロセスを導入し、大勢のステークホルダーとともに、新しいスマート・テック・アプリケーションの開発を行う「AIガバナンスコラボレーション」を強化することが必要であると考えている。

AI ガバナンスへの包括的なアプローチを適用していれば、寝たきりになった果樹農家のヨシダ氏のストーリーは、違った結末を迎えていたかもしれない。

以下のシナリオでは、AIを装備したパワードスーツを開発しているスズキ氏が、ヨシダ氏が再び歩けるように支援する新製品を開発する上で、私たちのガバナンスフレームワークをどう適用できるかについて説明する。

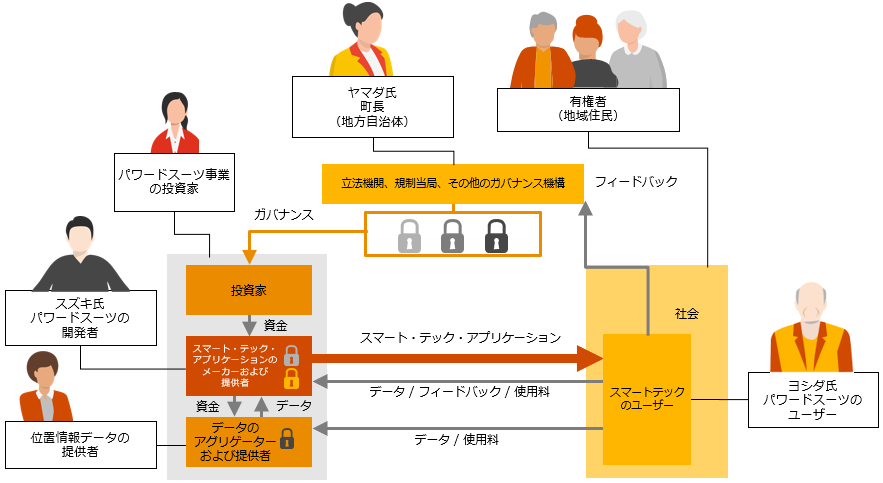

自律型パワードスーツの開発に主に関与しているのは、3名である。1) エンジニアのスズキ氏:スマート・テック・アプリケーションのメーカーと販売者の役割を担い、AIとロボット工学を使用しこのパワードスーツを開発している、2) パワードスーツを利用するヨシダ氏:AIユーザーの立場、3) パワードスーツが使用されている町の首長であるヤマダ氏:地方自治体を代表する立場。本レポートで先に取り上げた投資家、一般市民、立法機関、規制当局などのステークホルダーは、このシナリオでは取り上げない。

登場人物が地域社会の信頼を獲得し、ユーザーにとっての成功を達成するために必要なガバナンスを決定しながら、どのようにパワードスーツの開発を進めていくのか、その過程を追っていこう。これは1つの例であり、状況や人名は架空のものである。

ヨシダ・ヒロユキ氏は、山梨県飯野の近くに住む92歳の元果樹農家だ。彼と妻の間には2人の子どもがおり、それぞれ大阪と東京に住んでいる。60代になる子どもたちは結婚しており、それぞれ子どもと孫がいる。ヨシダ氏の妻ミチコは彼より少し年下で、健康である。 ヨシダ氏は引退するまでずっと、自宅から10km圏内の果樹園で仕事をしてきた。長年にわたる果樹園での重労働のため、彼の腰にかかっていた大きな負荷が蓄積したことで、ヨシダ氏は数年前に寝たきりになってしまった。妻は彼をかいがいしく世話し、ヨシダ氏の友人たち(多くは元農家)は頻繁に彼を訪問して勇気づけた。それでもヨシダ氏は次第に引きこもりがちになり、動けていた頃の活気に満ちた性格からは程遠くなってしまった。 最近になり、ヨシダ氏の子どもたちは、ビジョンを持った技術者、スズキ・マサタカ氏が経営する小さな企業を取り上げたテレビ番組を見た。スズキ氏は次世代のパワードスーツを製造する技術のライセンスを取得し、大手ロボット企業と連携していた。スズキ氏は、従来のパワードスーツはあまりにも決まり切った考えで設計されており、重い荷物や病院の患者、倉庫や工場にある重さや形状の不均一な物体を持ち上げるための補助としか考えられていないと確信していた。少しの投資、実験、そして運さえあれば、地元大学のAI研究室と協力し、ヨシダ氏のような人々を再び歩けるように支援できるAIを搭載したパワードスーツを開発できると感じたのだった。スズキ氏は、パワードスーツにAIを採用し、安定性と動きやすさを実現しようと考えた。センサーを搭載したパワードスーツは、着用者それぞれのバランスの取り方を計算に入れながら、地形の変化を予測し、着用者が意図したかすかな動きに正確に対応できる。 ヨシダ氏の子どもたちはスズキ氏に連絡をとった。家族と数回のミーティングを持ち、現在のプロトタイプを段階的にテストする必要性の説明が終わると、全員がそれを試すことに同意した。それ以降、スズキ氏は、ヨシダ氏と医師と緊密に連携をとり、パワードスーツをヨシダ氏の身体に合わせて調整し、AIに自律性を与えるための学習を行った。ヨシダ氏は大胆な目標を抱いていた。彼はまずパワードスーツを一人で着脱できるようになる必要があった。次に、家から平坦な細い道を歩いて15分の場所にある地域の果樹農協の建物で、友人と一杯楽しみたいと思っていた。理想的には、隣町にある病院まで医者や看護師を訪ねられるようになりたいと思っていた。それはつまり、バスの停留所まで歩いていき、道を渡り、2階の診察室まで階段を上って、家に帰ってくるということを意味する。 ヨシダ氏は最初の1週間で大幅な改善を見せたが、次の週は期待どおりにいかず、進歩が鈍っているように感じた。しかし、彼は筋力を取り戻すために選んだ定期的な運動を楽しんでいた。技術者のスズキ氏も非常に喜んだ。1年に及ぶ開発と改良を重ねた後、ついに実際のテストを始める時が来た。パワードスーツを毎日着用するのだ。 パワードスーツの開発と改良の間に実感した進歩により、ヨシダ氏は晴れやかな気持ちになっていた。彼はまだ孫やひ孫にどれくらい歩けるようになったか見せていなかった。歩いているところを直に見せて驚かせようと、楽しみにしていたのだった。ヨシダ氏は今や、奇妙な外観のパワードスーツにすっかりなじんでいる。彼が移動したいと思う方向を示すための体重移動を身に着けたし、家の前の平らな道でゆっくりと歩き始め、数分間の穏やかなジョギングに移行することもできるようになった。 最近では町長のヤマダ・エミ氏も興味を持ち、パワードスーツをもっと詳しく知りたいと思っていた。このスマート・テック・アプリケーションのおかげで、多くの高齢者が老後も活動的でいられるようになり、身体面の健康とともに精神面の幸福感が改善され、家族やコミュニティにより貢献できるようになるだろう。しかしヤマダ氏は少し不安に思っている。街の安全を守る責任を感じているからだ。もしヨシダ氏のパワードスーツが道路の横断中に止まってしまったらどうするか。また、バスの乗車中に不意に倒れ、運転手の邪魔をして事故を起こしてしまったらどうするか。 ヤマダ氏はスズキ氏と、こうしたリスクを軽減し、ヨシダ氏、近隣の人々、そして将来のパワードスーツ着用者の安全を守る方法について議論した。最初の9カ月が過ぎる頃には、パワードスーツを着用したヨシダ氏が、スズキ氏と彼の研究チームに伴われて次第に自宅から遠くまで歩いていく様子を地元の人々も見慣れてきた。ヨシダ氏は実際、一種の有名人になり、同じように運動機能障害を持つ地域の住民たちは、その装置のさらに新しく軽量になったバージョンのテストに志願してきた。 しかし、ある事故が起きたたことで、スズキ氏は別のAIを装置に組み込み、ヤマダ氏にパワードスーツの着用者や一般の住民を保護するための対策を急いで講じるように要請した。その事故とは、ある日、ヨシダ氏は病院の外でつまずいてしまったことだった。彼は通りがかりの人にぶつかり、倒れた通行人は額を切ってしまった。幸い通行人は無事に回復し、ヨシダ氏にけがはなかった。ヨシダ氏の担当医が検査を行ったところ、視力が徐々に悪化していることが分かった。そのため、縁石がよく見えず、パワードスーツに足を降ろすよう「伝える」ための体重移動ができなかったことが分かった。 この事故をきっかけにヤマダ氏は、地域社会やパワードスーツ着用者のリスクを最小限に抑えるため、「パワードスーツ着用ライセンス」プロセスを開発することを思いついた。ヨシダ氏がパワードスーツを使用している時、スズキ氏が彼の健康状態のデータを収集していたのは、このためでもある。このデータは、ヨシダ氏がどう行動しているかを医師がモニターするのに役立ち、また新しい眼鏡や追加の物理療法といった治療や介入が必要な時期を特定するのに役立つだろう。またスズキ氏は、収集したデータをさかのぼってラベルを付け、どんな状況で収集されたかを認識すべきだと考えた。例えば着用者の健康状態のパラメータを、通常のGPSの位置情報やパワードスーツの動きにタグ付けした。これによって、次の着用者に備えてパワードスーツのAIを学習させる際、適切なデータをフィルタリングすることができる。スズキ氏はまた、ヨシダ氏と一緒に行ったワンステップずつのアプローチではなく、次の製品に備えて、より包括的で徹底的なAIガバナンスプロセスを作成する必要にも気付いた。 パワードスーツのおかげで、ヨシダ氏は他の手段では成しえなかった「動ける4年間」の恩恵を受けた。またこうしたハイテク「ヘルパー」と最初に歩いたことを誇りにも思っている。そして2人の友人もできた。スズキ氏とヤマダ氏だ。昔の農家時代の友とも再び付き合うようになった。彼はもはや、妻に負担をかける存在ではない。これらすべてが素晴らしい進歩だが、彼が最も嬉しかったのは、ひ孫と連れ立って長い散歩をしている時、ひ孫が「機械の体を手に入れた」ひいおじいちゃんに感心し、尊敬のまなざしを向けていることに気付いた時だった。 |

図表4は、それぞれの登場人物が、スマート・テック・アプリケーションの設計、開発、利用、保守のプロセスの中で位置づけられる役割を示している。

主なステークホルダーによって実行される、AIガバナンスの各段階を見ていこう。

パワードスーツのスマートテクノロジー開発者であるスズキ氏は、設計、テスト、継続的な改善という開発の各段階に適切なレベルのAIガバナンスを統合し、信頼性の高いスマートテクノロジーソリューションの開発に着手した。そのために次のことを行った。

スズキ氏はまず、ヨシダ氏とその家族に対して、パワードスーツの技術、現実的なリスクと利点について、時間をかけて説明した。パワードスーツがどう機能するのか。ヨシダ氏のニーズにどう適合するのか。機能面の課題を解消するには数カ月かかる可能性があり、ヨシダ氏の忍耐と決意が必要であること。ヨシダ氏が負うであろうリスクと、それにも関わらず最終的に役に立たないかもしれないというリスク。新しい機能は段階的にテストし、開発のすべての段階でヨシダ氏と彼の家族への確認を必ず行うことも説明した。

どのようなデータを収集しているのかについて詳細に説明した。ヨシダ氏の体験をパーソナライズする上でそのデータをどう活用するのか。ヨシダ氏のパワードスーツの全体的な改善や、今後のパワードスーツ着用者のための活用方法についても説明を行った。またスズキ氏はヨシダ氏に対し、スズキ氏の会社とのデータ共有を断る選択肢があることと、その意味についても説明した。

スズキ氏は、AIアルゴリズムが高精度の位置情報データを使用していることを確認した。まず、位置情報データの提供者と一般的な精度について確認し、次にヨシダ氏がパワードスーツを使用することが予想される正確な地域内において、位置情報データの精度のテストを実施した。

スズキ氏はまた、最終的に動作制御に使われる学習データにパワードスーツの前方および周囲の生の画像を与えることで、多様な環境に十分対応でき、ヨシダ氏が横断する道路や歩行者区域を認識できることを確認した。位置情報データのノイズを除去するために、データクレンジング対策が追加で実施された。

スズキ氏は、選択したデータサンプルの検証だけでなくリアルタイムのデータ収集により、リアルタイムでの動きの調整やユーザーへの危険回避の警告を含む、テクノロジーのパフォーマンスの監視ができることを確認した。またこれにより、より多くのデータを得た。それは他のユーザーが類似のパワードスーツを使用する際のトレーニングと、さまざまな環境でのデータを分析してコンピュータビジョンの環境検出精度を向上させるために使用できた。

パワードスーツの使用が予想されるすべての条件や場所において、ヨシダ氏の体重を安全に運べるように基本設計されていることを確認した。さらにヨシダ氏が自分の体形と体力に合わせてわずかに体を動かすだけで、パワードスーツとの「コミュニケーション」がとれるようにした。

パワードスーツの「靴」が、ヨシダ氏の家の周辺、町内の道路や歩道、階段の上り下り、バスの中など、ヨシダ氏がパワードスーツで歩くことが予測される歩行面に対応していることを確認した。

スズキ氏は、テストの全体を通して段階的に進めていくことに留意した。スズキ氏自身、ヨシダ氏、そしてヤマダ氏の三者が実際の条件下でテストしても安全だと感じるようになるまで、徐々にタスクの難易度を上げていった。

スズキ氏はまた、定期的にトレーニングにも立ち合い、装置がまだテストされていなかったり、あるいは安全が確認されていなかったりする条件については、はっきりと警告した。それは例えば、「舗装された道路だけを歩いてください」といったものだ。

ヤマダ氏とその地域住民に対しても、時間をかけてリスクと利点の説明を行った。

これらのステップを踏むことにより開発期間は長期化したが、地域社会の中にパワードスーツを導入することに伴う短期的なリスクを最小限に抑えることにつながった。公共の安全に問題を生じることなく、パワードスーツは地域の高齢者の運動機能を高め、老齢期の幸福を支援するものだという信頼性を高める結果となった。

ヨシダ氏もまた、自分の責任を真剣に受けとめていた。

ヨシダ氏は時間をかけて、パワードスーツの利点とリスク、その技術、安全かつ漸進的な使用方法、そしてヨシダ氏がとるべき行動を理解した。筋力を高め、パワードスーツの操作能力を向上するための定期的な運動もその1つだった。

ヨシダ氏は、雨などの悪条件のもとでのテストを実施し、設計時に想定された条件以外でパワードスーツを使用した際のリスクを直接体験することに同意した。

ヨシダ氏はスズキ氏に、詳細なフィードバックを提供した。おかげでパワードスーツのAIを、自分自身のため、またAI対応パワードスーツの将来のユーザーのために改善することができた。

最後に、町長のヤマダ氏は、地域住民の代表として利害関係のトレードオフ、つまり事故や利点が発生した場合の社会のリスクと、成功した場合の利点について早い段階で理解した。該当する法律がなかったため、国の指針と彼女自身の常識を基準とした。

ヤマダ氏は、関連する技術と、それらを公共の空間(道路、歩道、建物、交通機関)で安全に利用する方法、個人およびそのコミュニティと社会にとってのリスクと利点について、時間をかけて理解した。

例えば「パワードスーツ装着ライセンス」の地方自治体独自のパイロット試験を計画する前には、国の関係当局の支援のもと、ヨシダ氏の視覚の不測の変化に対応するために、第三者、例えばヨシダ氏の担当医への相談を行った。ヤマダ氏はユーザーに対し、ライセンスの取得のためには、毎年または必要に応じてより頻繁に、身体能力テストと認知テストに合格すること、また担当医および理学療法士からの推薦状を取得することを要求した。

ヨシダ氏とスズキ氏がコミュニティ内で行っているこの胸躍る実験について、ヤマダ氏は地域住民と頻繁に意見を交換した。パワードスーツを装着したヨシダ氏が近くを歩いている時や、車に乗って道路を通り過ぎていく時などは、人々にその利点やリスクを認識するよう促した。

このストーリーでは、産業用ロボットやAIに関連した組織については明確に説明していない。そうした組織も、この実験から学び、AIパワードスーツが安全のためのバックアップを備え、ときには着用者がAIに優先して判断できるための認証プロセスの開発を検討している。また、パワードスーツ事業への投資家についても言及していない。投資家は事業の迅速な拡大には関心を持っているが、リスクを取ることには慎重であり、完成度の高いパワードスーツの開発についてスズキ氏と緊密に協議している。

それでは概念式内の要素と、各ステークホルダーが使用するガバナンスの定義方法、またその理由について見ていくことにしよう。

使用されるAI技術の種類:スズキ氏はパワードスーツの開発に数種類のAI技術を利用した。考慮すべき事柄は2 つある。

位置情報―GPS の位置データに基づいて装置の所在地を検索することは、非常に成熟した技術である。しかしスズキ氏は、ヨシダ氏がパワードスーツを使用する可能性のあるすべての地域で、良好な受信状態を確保したいと考えた。そのため、彼はいくつかの具体的なテストを実施した。

膝パッドにかかる圧力の解析による動作方向の決定― これは公共の場所でのテストがほとんど行われていない新しい技術である。そのため、スズキ氏はテストを段階的に行うことにした。

社会的価値観:日本のロボット技術に対する開放性が、ヨシダ氏がパワードスーツを早期に着用できることにつながった。ヨシダ氏はテストに関するパフォーマンスデータと個人データを喜んで共有したため、スズキ氏とヤマダ氏のパワードスーツのパフォーマンスに関する知識は増した。それは地域社会の中で、他のパワードスーツの実験を加速することにつながった。

使用されるデータのプライバシーレベル と 影響を受ける人数:パワードスーツから収集したデータは匿名化され、ヨシダ氏や将来のパワードスーツ着用者のために動作精度を向上させるためのAIの学習に使われた。

リスクの重大性と確率:このパワードスーツは、ヨシダ氏のために商品化する前に、厳格な試験と改良が施された。次の段階では、スズキ氏は引き続きヨシダ氏の住む町において、高齢者のためのパワードスーツの改良に向けた大規模なテストを行うつもりだ。ロボット工学の企業は、規模の拡大の支援を提案してきた。また日本の厚生労働省は、スズキ氏のパワードスーツをテストする病院の候補を示すといった協力を申し出た。スズキ氏は、これらの取り組みのうち、自身が並行して安全に指揮できるものはいくつあるのかチェックしている。

AIガバナンスツールの範囲: ヤマダ氏はガバナンスのギャップに気付き、政府と協力して、地域での「パワードスーツ着用ライセンス」を導入した。スズキ氏は次の開発ステップに進む前に、適切なAIガバナンスプロセスを設計する必要があることを認識した。

この例は、ガバナンスの責任の共有、事故や失敗のリスクの軽減、ヨシダ氏のパワードスーツの成功がコラボレーションによってどのように実現されたのかを示すものである。登場人物の緊密な連携により、パワードスーツのさらなる開発への道が開かれ、運動機能の低下に対するこの革新的なソリューションの利用の可能性がさらに広がった。

このストーリーは、私たちが提唱するホリスティックかつオープン、プロポーショナル、そしてエンドツーエンドなAIガバナンスプロセスの実践的な応用例を示している。

PwCとユーラシア・グループは、スマート・テック・アプリケーションが広く浸透するには、社会が、スマート・テック・アプリケーションが、一貫性のある包括的かつ明確な方法で確実にテストされたことを信用した場合にのみ、実現できると考えている。これまでのところ、多くのガバナンスは、何らかの事案が発生し、解決すべき問題が特定された後に実施されている。より優れたアプローチは先を見越して動くことであり、より包括的なこのAIガバナンスアプローチをPwCが提案する理由はそこにある。

私たちは、スマート・テック・アプリケーションの成功において、AIガバナンスがどう貢献できるか議論する上で、本レポートが有益かつ実用的に役立つことを期待している。また、ご紹介した事例が、ステークホルダーと共同で、ホリスティックかつオープン、プロポーショナル、そしてエンドツーエンドなAIガバナンスを実装する場合の、最適解を示していることを願ってやまない。

スマート・テック・アプリケーションの設計、開発、利用、保守を担う組織が、PwCのResponsible AI(責任あるAI)フレームワークとツールキットを活用し適切なガバナンスステップを実装することで、それぞれのスマート・テック・アプリケーション特有のリスクに対処することも期待している。

最後に、立法機関、規制当局、その他のガバナンス機関が、AIガバナンスコミュニケーションプラットフォームの構築を奨励し、ユーザーや国民からの信頼性向上および維持を支援する重要性も改めて強調したい。

政府と企業が連携し、よりオープンなAIガバナンスアプローチを促進すれば、スマートテクノロジーの故障のリスクが軽減され、スマート・テック・アプリケーションの開発に対する国民の信頼が強化されるだろう。これこそが、スマート・テック・アプリケーションの開発に不可欠な、長期的な信頼を構築する最善の方法である。またこれこそが、より人間中心のAIガバナンスを構築するための最善の方法なのだ。

{{item.text}}

{{item.text}}