{{item.title}}

{{item.text}}

{{item.text}}

2023-03-29

2023年2月22日開催の第4回研究会をご視聴いただきまして、厚く御礼申し上げます。今回は、生成技術の技術動向とそれに伴うリスクに関するAI活用の盲点をテーマに、課題や対策についてディスカッションしました。

第1部の配信では、お2人の方にご登壇いただきました。

日本マイクロソフト株式会社 業務執行役員 ナショナルテクノロジーオフィサー 田丸健三郎氏より、マイクロソフトにおける生成技術への挑戦や、技術の現場で感じる課題についてお話しいただきました。Chat GPT はコードを自動生成することができ、コードの自動生成は、VSコードやgit hub上でサービス提供されています。一般にアクセス可能なデータをもとにした学習を行っており、各企業の内部の言語資源を追加学習させることもできます。社内情報を学習させた場合、社内のメンバーに質問するよりも、Chat GPT に会社について質問した方が的を射た回答が返ってくることもあるそうです。

一方で、課題はまだたくさんありそうです。企業や企業内の各組織には異なるコンプライアンスルールが設けられていることが多く、「大規模モデルにおけるセキュリティや倫理の問題をどのようにコントロールしていくのか」「現実的に、どこまで商用化が可能なのか」といった課題があります。例えば、Chat GPTでは学習したデータの範囲で回答を行いますが、追加学習を行う際のコストが高額であるため、商用化の限界を考える必要があります。この他にも、大規模モデルの学習にはオープンデータが含まれていますが、データの提供者に対する利益の分配がなされていないという問題や、学習データとアウトプット間の因果関係が不明瞭であるなど解決が難しい課題も存在しています。

合成ダイヤモンドを作製する技術と、それを識別する技術がそうであったように、人工的に特定のアウトプットを作成する技術と、それら人工的に作成されたかアウトプットかを判定する技術は並行して発展するケースが一般的です。生成技術も同様で、「論文を生成する」「レンブラントの絵画を生成する」「人物画像を生成する」といった技術とともに、それらを識別する技術も研究が進められています。

生成技術はまだ発展途上ですが、例えば、国会の答弁の矛盾点を抽出するなど、これまでヒトの手ではなかなか難しいとされていた場面での活用も考えられ、可能性の広さが伺えます。

生成技術はまだ発展途上ですが、例えば、国会の答弁の矛盾点を抽出するなど、これまでヒトの手ではなかなか難しいとされていた場面での活用も考えられ、可能性の広さが伺えます。

続いて、PwC弁護士法人 パートナー弁護士 茂木諭 および 弁護士 矢野貴之が生成技術に係るリスクについて解説しました。法的なリスクとして、主に著作権に関する問題を取り上げました。例えば、AI生成物の著作権に基づき第三者に対して損害賠償請求を行う場面や、AI生成物が第三者の著作権を侵害してしまい損害賠償請求を受ける場面が考えられます。

AI生成物の著作物性を検討するためには、「生成された画像が著作物として認められるのか」を考える必要があります。AIモデルの背後にいるヒトが著作者として認められるかどうかが論点となりますが、その際、ヒトによる創作的寄与が認められるかどうかがポイントとなります。ヒトがAIモデルを活用する場面としては、(1)AIモデルに大まかな指示を行う場合、と(2)AIを道具として使用する場合があります。このうち(2)では著作権が認められ、制作者が著作者となります。(2)の例としては、利用者がAI生成物に手を加えるようなケースが考えられます。学習データを準備して追加学習を行うことが創作的寄与に当たるかどうかについては、ケースバイケースの判断になりますが、学習データ自体の創作や学習データの選択等への関与度合いによっては、創作的寄与が認められることもあり得ます。

著作権の侵害については、類似性と依拠性の2つの要素が関係しますが、AIモデルにおける著作権侵害の場合、特に依拠性がポイントとなります。AI生成物についてどのような場合に元の著作物への依拠性が認められるのかについてはさまざまな見解があり、議論がされています。学習したデータセットに元の著作物が含まれており、それがモデルのパラメータ生成に影響を与えている場合には依拠性が認められるとする見解が有力ですが、パラメータ生成への影響の有無を判定することは技術的に難しく、今後の課題と言えるでしょう。

また、架空の人物を生成した画像データを広告などに利用した場合、その架空の人物と実在の人物との類似性や利用態様によっては、パブリシティ権や肖像権が問題とされる可能性もあります。

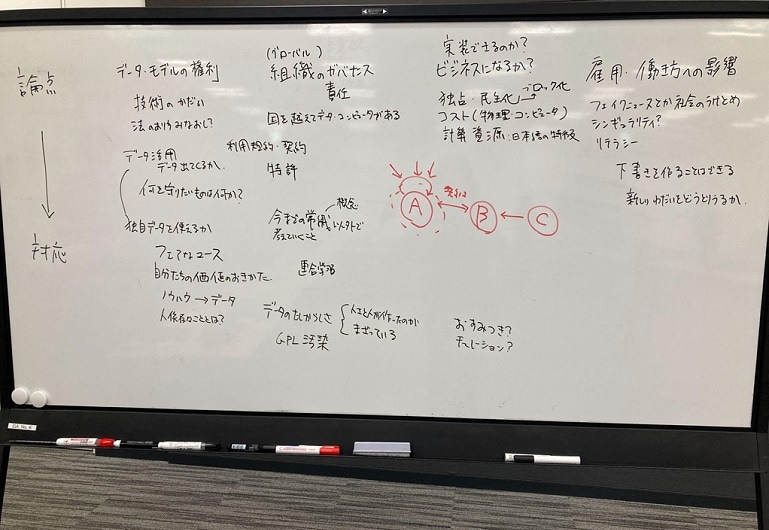

第2部は江間有沙准教授のリードのもと、第1部の配信内容を基にディスカッションを実施しました。今回の研究会も、企業や政府機関でAIの利活用に関わる方々にご参加いただき、議論を発散させる方向で進めました。

生成技術に関して、今後議論すべきポイントはたくさんあります。法的にどのようなリスクが考えられるか。著作権を含むそのような法的リスクについて、ステークホルダーを納得させられるのか。生成技術の発展とともに社会が具体的にどのように変化していくのか。機密データを守りながら生成技術をどのように活用できるか。ヒトはどのように本当らしい嘘と接していくべきか。シンギュラリティが来たと言えるのか――。さまざまなポイントが会場でも挙げられ、一日で全てを取り上げることは難しかったですが、今後の議論ポイントとしては、

技術的に何ができるのか(できないのか)

組織のガバナンスをどのように設計していくべきか、組織としてのどのように責任を果たすべきか

どのようなビジネスに発展していくか(実際に活用することができるのか、独占となるか民主化に進むか)

雇用や働き方にどのような影響を与えていくか

今後の技術変化に伴うコンプライアンス対応の変化

などが含まれると思われます。また、日本と海外との法律の違いも注意深く確認する必要があります。

企業におけるデータ活用戦略についても、生成技術の発展に伴って課題が生じています。社内のデータ整備が追いついておらず、活用できないデータの存在や、今後守るべきものと公開すべきものの取捨選択、ネット上に散乱するデータの生成過程有無の識別などの課題があります。生成技術の発展によりデータの確からしさを見極めることがより難しくなると考えられますが、その対策として、データが生成されたものか否かを判別するためのAIモデルもすでに開発されています。しかし、全てのAIやデータを確認することは現実的ではなく、データの信憑性の確認は、専門家に依存することになるかもしれません。最終的なチェックはヒトの仕事となるのです。

今回は、生成技術について議論を行いましたが、AIガバナンスの観点では、これまでのAI技術やそれに伴うリスクと大きく変わることなく、これまでの研究会で取り上げた論点も多く含まれていました。生成技術を全体の中でどのように位置づけていくのか、今後も議論を続けます。